作者:阿中哥 + AI 協助彙整。 【本文約有4,374字】

突飛猛進的AI:O3 與 O1 模型觀測報告書

一、引言

本報告旨在分析 OpenAI 最新發布的 O3 模型與其前代模型 O1 的性能與能力差異。O3 作為新一代推理模型,展現了在程式設計、數學推理及綜合智慧能力上的顯著提升。以下內容將從技術性能、實際應用能力、安全性與成本效益等角度進行全面對比。

二、性能對比

- 程式設計能力

- 基準測試:Codeforces ELO

- O1 模型:ELO 評分 1891。

- O3 模型:ELO 評分 2727,相較 O1 提升超過 40%。

- 觀測結論:

- O3 在程式競賽環境中展現了極高的邏輯推理與程式生成能力,表現超越專業人類程式競賽選手。

- 軟體開發測試:Bench Verified

- O1 模型:正確率約 51%。

- O3 模型:正確率達 71.7%,提升超過 20%。

- 觀測結論:

- O3 能更準確地解決實際軟體開發問題,增強了實用性。

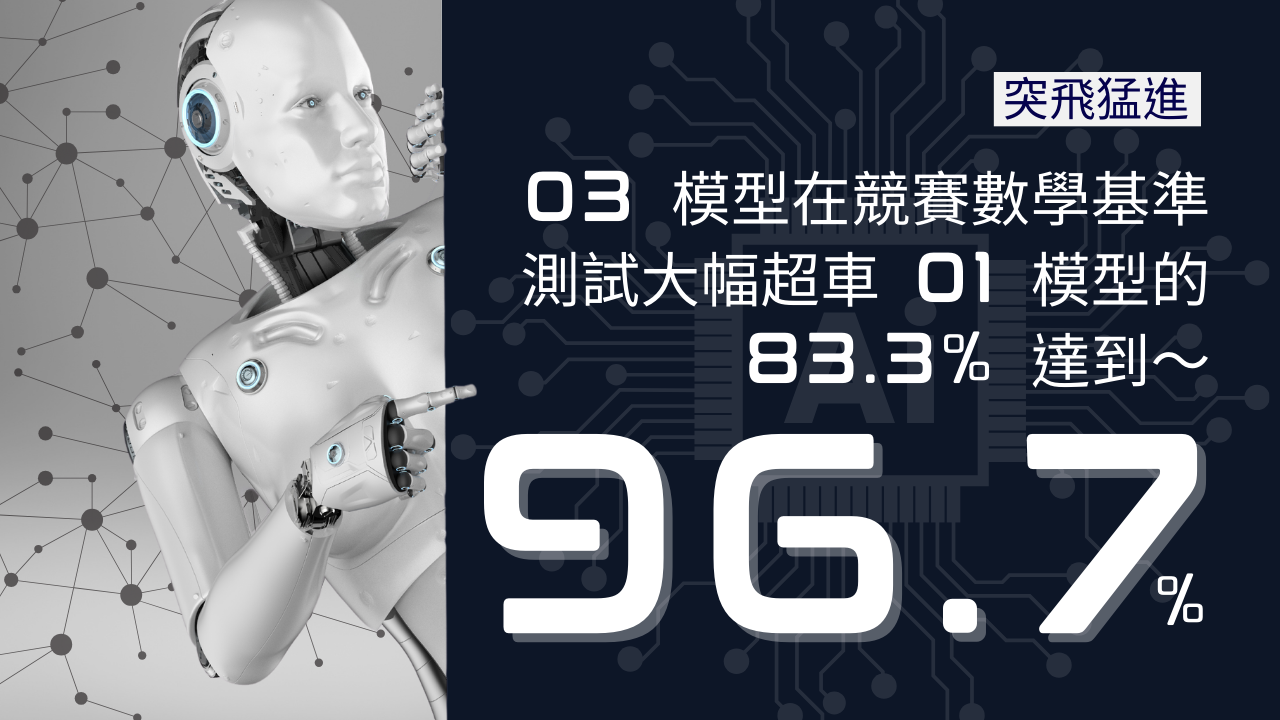

- 數學推理能力

- AMI 測試(美國數學奧林匹亞選拔測試)

- O1 模型:正確率 83.3%。

- O3 模型:正確率 96.7%,提升超過 13%。

- 觀測結論:

- O3 的數學推理能力幾乎達到「滿分」,僅少數題目未完全答對,顯示其在數學推理方面的卓越能力。

- Epic AI Frontier Math Benchmark

- O1 模型:正確率低於 2%。

- O3 模型:正確率達 25%。

- 觀測結論:

- 在最困難的數學基準測試中,O3 展現了顯著進步,對於解決高難度數學問題具有更高效的能力。

- 綜合智慧能力

- GPQA Diamond 測試

- 測試內容:博士級科學問題。

- O1 模型:正確率 78%。

- O3 模型:正確率 87.7%,提升近 10%。

- 觀測結論:

- O3 在高層次科學問題上的表現接近人類專家水準,展現了跨領域的推理與學習能力。

- ARC AGI 測試

- 測試內容:學習新技能的能力。

- O1 模型:未能通過測試。

- O3 模型:低運算資源下得分 75.7%,高運算資源下達到 87.5%。

- 觀測結論:

- O3 是首個在 ARC AGI 測試中超越人類平均表現的模型,顯示其具備突破性的一般化推理能力。

三、安全性與成本效益

- 安全性

- 新技術應用:深思熟慮的對齊(Deliberative Alignment)

- O3 模型引入推理能力以強化安全性,能更準確地分辨安全與不安全請求。

- 相較 O1,O3 拒絕錯誤率降低,同時拒絕準確性提高。

- 觀測結論:

- O3 在安全性方面展現顯著進步,尤其適合應用於需要高度安全保障的場景。

- 成本效益

- 計算效率提升

- O3 模型在提供更高性能的同時,顯著降低運算延遲。

- 比較:

- O1 模型平均反應時間較高。

- O3 模型在低推理模式下的響應速度幾乎達到「即時回應」水準。

- 觀測結論:

- O3 提供了更高效且具成本效益的解決方案,適合大規模部署。

四、實際應用與影響

- 編程輔助:

- O3 模型在開發者社群中的應用將極大提升代碼生成與最佳化效率。

- 教育與研究:

- 其數學推理能力適用於高等教育與科研領域。

- 安全關鍵應用:

- 改進的安全性使其適合於金融、醫療等高敏感度領域。

五、總結與建議

- O3 模型的突破性進展:

- 相較 O1,O3 在程式設計、數學推理及綜合智慧能力上均有顯著進步。

- 其突破性的安全與成本效益使其成為應用於多領域的理想選擇。

- 未來建議:

- 提升模型泛用性:持續最佳化模型學習新技能的能力,進一步縮小與人類專家之間的差距。

- 擴展應用場景:探索在金融風險管理、科學研究輔助等高效能場景中的應用。

O3 模型的發布標誌著 AI 進入新高度,未來有望在更多領域引領技術革新。

關於:Codeforces ELO 的用途與公正客觀性分析

- Codeforces ELO 的用途

Codeforces ELO 是用於衡量競賽程式設計選手實力的一種評分系統,類似於西洋棋中的 ELO 評分,主要應用於以下方面:

- 選手實力評估:

- 通過參加 Codeforces 平台上的程式競賽,每位選手會根據比賽表現獲得一個動態調整的 ELO 分數,表示其編程和算法能力的水準。

- 評分可以幫助選手了解自己在全球程式競賽社群中的相對排名,進一步明確提升方向。

- 比賽難度匹配:

- Codeforces 根據選手 ELO 分數,為不同實力層級的選手分配適合的題目難度。

- 選手的分數越高,他們參加的比賽通常難度越高,從而保證比賽的公平性和挑戰性。

- 模型性能測試基準:

- AI 模型(如 OpenAI 的 O3 模型)可以參與 Codeforces 測試,通過解題過程獲得 ELO 分數,這為模型提供了一個與人類競賽選手直接對比的客觀指標。

- 公正客觀性分析

ELO 系統的公正性特點

- 基於對戰表現的即時調整:

- ELO 評分根據選手在比賽中的表現進行動態更新,能準確反映其當前實力。

- 例如,如果一位選手在與實力更高的對手競爭中勝出,則其評分增加幅度會更大。

- 數學模型的透明性:

- ELO 的計算方法基於簡單而明確的數學公式,主要考慮選手的當前評分、對手實力以及比賽結果,避免了人工干預的主觀性。

- 持續參與反映長期實力:

- 評分是動態的,選手需持續參加比賽,才能維持或提高評分。這避免了短期偶然事件對評分的過大影響。

ELO 系統的潛在局限

- 初始評分偏差:

- 新進選手的初始評分可能未能完全反映其真實實力,需要經過多次比賽才能穩定。

- 比賽題目質量影響:

- 如果比賽題目設計不均衡,可能影響選手表現,進而影響評分準確性。

- 對模型評估的局限:

- 雖然 Codeforces ELO 可用於 AI 模型測試,但模型通常使用高運算能力進行解題,與人類選手的真實挑戰情境(如時間壓力、現場思考能力)有一定差異。

綜合評價

整體而言,Codeforces ELO 作為一種透明且基於數據的評分系統,在人類競賽中具有高度的公正性和客觀性。但在用於 AI 模型性能測試時,仍需結合其他評估標準(如運算資源使用效率、創新解題能力)以進一步補充。

- 結論

Codeforces ELO 作為競賽選手實力的標準評估指標,廣泛用於程式設計領域,具備較高的公正性與客觀性。其在 AI 模型測試中的應用提供了人機比較的重要參考,但應考慮不同環境下的挑戰特性,以避免評估單一化。

關於:Bench Verified 的用途與公正客觀性分析

- Bench Verified 的用途

Bench Verified 是一套專門針對真實軟體開發任務設計的測試基準,其主要用途包括以下幾個方面:

- 模型編程能力測試:

- Bench Verified 測試模型是否能在現實場景中完成具挑戰性的軟體開發任務,例如編寫程式碼、修復漏洞、最佳化現有程式等。

- 測試結果能有效反映模型的程式理解、生成能力及問題解決能力。

- 人機編程能力對比:

- 透過 Bench Verified,可以將 AI 模型的性能與人類開發者進行對比,了解 AI 在真實軟體任務中的表現是否能與專業開發者媲美。

- 模型改進的指導方向:

- 測試過程中,Bench Verified 能識別模型在編碼邏輯、語法生成及問題解決中的薄弱點,為模型設計者提供改進方向。

- AI 編程模型的市場應用標準:

- Bench Verified 的結果可作為衡量 AI 模型是否適合用於實際商業環境的客觀依據,幫助企業選擇最適合的解決方案。

- Bench Verified 的公正客觀性分析

公正性優勢

- 基於真實軟體場景的測試:

- Bench Verified 的測試任務來自於實際軟體開發問題,具有很高的實用性,避免了單純理論或合成數據的局限。

- 多樣化測試任務:

- 測試範圍涵蓋不同的程式語言、框架及開發任務,從而能全面反映模型的能力,避免因測試內容單一而造成的偏差。

- 固定標準評估方法:

- Bench Verified 採用固定的評分標準,例如根據任務完成的正確率、效率及生成代碼的質量(如可讀性、執行性能等)進行評估,確保評分的一致性。

- 與人類基準對比:

- 通過與人類專業開發者的表現進行對比,Bench Verified 能更清楚地定位模型的能力水準。

潛在局限性與挑戰

- 測試範圍的有限性:

- 雖然 Bench Verified 涵蓋多樣化任務,但仍可能無法完全涵蓋軟體開發中所有的場景,尤其是某些極具創意性或非結構化的任務。

- 結果依賴輸入質量:

- 模型的表現可能受到測試任務描述是否清晰的影響,對於高模糊性的任務,結果可能低於預期。

- 對 AI 模型的資源依賴:

- AI 模型通常利用大量算力完成任務,而 Bench Verified 並未針對資源效率進行評估,可能導致人機表現對比時的公平性略有偏差。

- 人工標注驗證:

- 對於生成代碼的正確性判定,Bench Verified 在某些情況下仍需人工驗證,這可能引入一定的主觀性。

- 綜合評價

公正客觀性的結論

- Bench Verified 通過測試真實軟體場景的任務,能夠較為準確、公正地評估模型在程式設計中的實用性。

- 它的多樣化任務設計和固定評分標準,降低了測試過程中的偏差,確保了測試結果的可靠性。

- 然而,在應用到更廣泛場景時,需結合其他評估標準(如資源效率和創造性測試),以更全面反映模型的能力。

- 總結

Bench Verified 是一種專注於真實軟體開發場景的測試基準,其測試結果能有效反映模型在實際應用中的能力。作為一個衡量標準,其公正性與客觀性已經被廣泛認可,但在應對更加多樣化的軟體開發需求時,仍有進一步完善的空間。

關於:Epic AI Frontier Math Benchmark 的用途與公正客觀性分析

- Epic AI Frontier Math Benchmark 的用途

- 測試數學推理能力:

- 此基準涵蓋極具挑戰性的未公開數學問題,能有效衡量模型在處理未知數學推理問題上的能力。

- 測試範圍包括代數、幾何、數論和微積分等多個數學領域,提供全面的數學能力評估。

- 識別推理瓶頸:

- 該基準設計為高難度數學題目,針對 AI 模型的極限性能進行挑戰,幫助研究者了解模型在哪些方面仍存在不足。

- 推動 AI 數學研究進展:

- Frontier Math Benchmark 為學術界提供了一個統一的參考標準,用於評估新模型是否能在數學推理領域取得突破。

- 一般化能力測試:

- 此基準包含的題目非公開且具高新穎性,能測試模型是否具備學習和解決從未見過問題的能力,避免過度依賴記憶或訓練數據。

- 公正客觀性分析

- 題目來源真實且多樣化:

- Benchmark 的題目來自未公開的數學問題,包括科研級挑戰題,確保題目新穎性,避免 AI 模型從訓練數據中記住答案。

- 題目難度覆蓋範圍廣泛,從本科數學到博士研究級別,能全面測試模型的推理能力。

- 統一評估標準:

- 測試使用固定的正確率和解題成功率作為評估指標,評分過程客觀且一致。

- 同時,所有測試模型需在相同的條件下進行測試(如相同的運算資源限制)。

- 與人類基準的比較:

- Frontier Math Benchmark 同時收集人類專家(如數學家)的解題表現,用於建立人類基準(Baseline),從而將 AI 模型的表現與人類進行對比。

- 高難度保證模型挑戰性:

- 該基準中的問題被設計為非常困難,即使對人類數學家而言,解答也需要耗費數小時甚至數天。

- AI 模型在此測試中的表現能顯示其在接近人類專家能力時的真實進展。

- 不均衡題目難度:

- 雖然題目多樣化,但個別題目可能過於偏向特定數學分支,對於通用模型而言可能不完全公平。

- 資源需求差異:

- 不同模型使用的計算資源可能影響其解題效率,可能導致在模型間比較時的偏差。

- 如果未嚴格控制測試運算資源,可能影響結果的可比性。

- 專家基準的限制:

- 雖然以人類專家作為基準,但專家解題的條件(如時間壓力、輔助工具)與 AI 測試環境可能有所不同,這可能導致對 AI 和人類能力的直接比較存在偏差。

- 對 AI 訓練方法的依賴:

- 如果某些模型在訓練中使用了與 Frontier Math Benchmark 類似的題目,其測試結果可能會受益於訓練過程,從而低估其他模型的性能。

- 綜合評價

- 高度公正性:Frontier Math Benchmark 的題目來源未公開,且測試範圍廣泛,能有效避免模型依賴記憶和重複性數據,具有高度的挑戰性。

- 客觀評估方法:統一的正確率評估和與人類基準的比較,保證了測試結果的可靠性。

- 改進空間:需進一步完善題目設計的均衡性,並加強資源使用條件的統一性,以避免因條件差異導致的偏差。

- 總結

後記

這是在 2024-12-21 (六) 看到了 Open AI 的 12 日發布的最後一次發布,果然推出了更重磅的消息,就是宣告 O3 模型的消息,預計在下個月,也就是 2025 的 1 月份,即將先行推出 O3-mini。實在是太讚了。