Athene-V2 開源模型運行之GPU租賃報告書

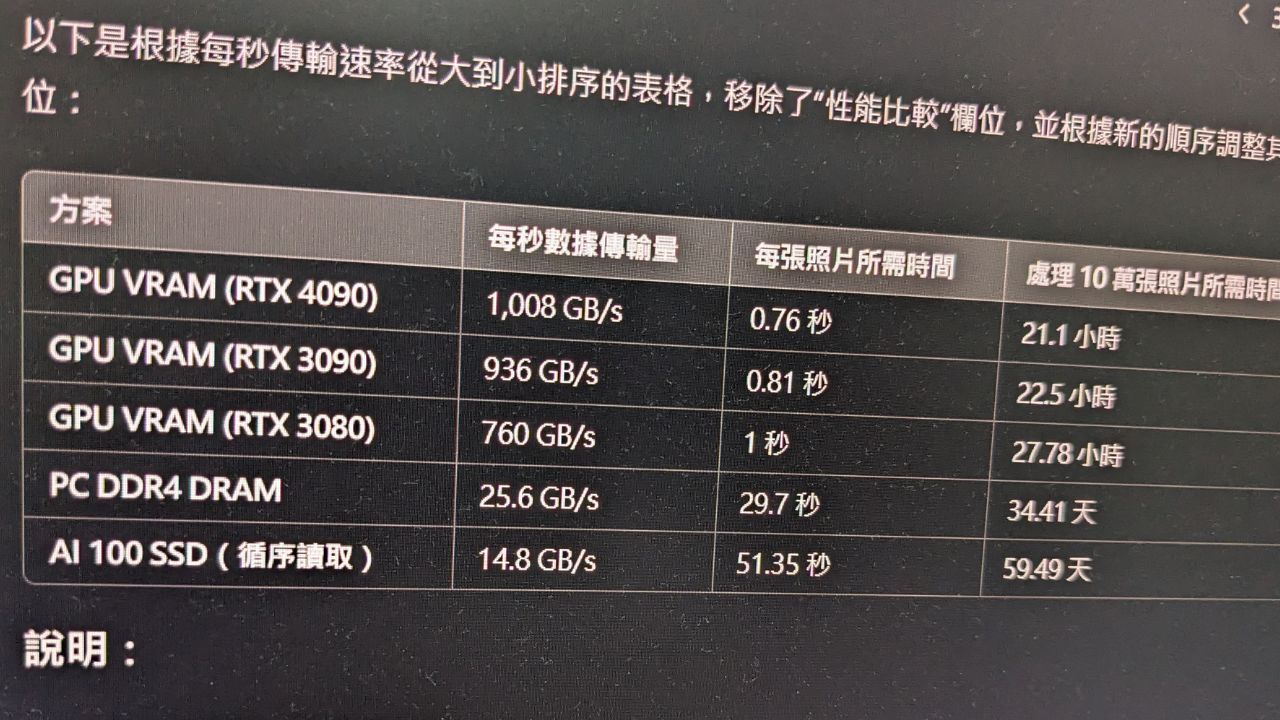

Athene-V2 是一款多語言的大型語言模型(LLM),具備卓越的自然語言處理能力,適用於企業級推論、內容生成與 AI 服務等多種場景,該模型需要高性能 GPU 支持,其運行需求包括 VRAM 至少 145GB,並能處理 32,000 個 tokens 的上下文長度。GPU 選擇方面,NVIDIA H100 (SXM5) 具備最快的推論速度(15-30 秒),而 NVIDIA L40S 在性能與成本間取得良好平衡,適合中型企業應用,經濟型選擇如 RTX 3090 和 RTX 4090 則適合初創企業和小型專案。GPU 租賃成本分析表明,企業可根據業務需求選擇不同配置,短期內可用經濟型 GPU 測試,長期需求則建議使用 H100 系列或 L40S。此報告為企業提供了一個在地端運作 Athene-V2 模型的明確參考依據。